El próximo 28 de noviembre, el broadcast gratuito DCD>Innovación y Diseño Latam también contará con expertos del sector para destacar las innovaciones de la industria.

Fuente: www.datacenterdynamics.com

La pandemia ha provocado un notable aumento en la cantidad de datos, lo que ha resultado en una creciente demanda de nuevos data centers en América Latina. Hemos observado la aparición de mercados en crecimiento, como Querétaro en México y São Paulo en Brasil.

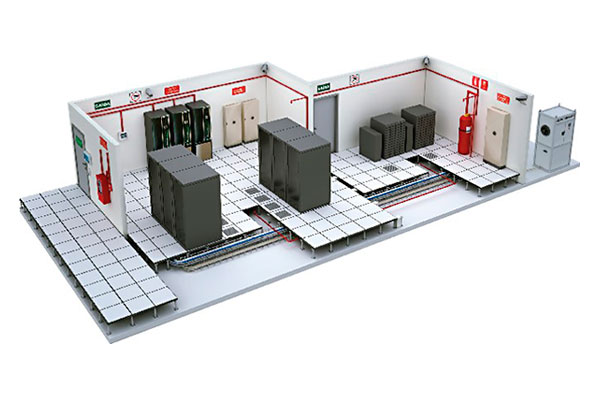

Los responsables del diseño tuvieron que adaptarse a estas crecientes demandas, y hemos sido testigos de la emergencia de nuevas metodologías en el mercado. Los diseñadores buscan soluciones cada vez más eficientes que puedan ser entregadas en plazos cada vez más cortos, ya que el diseño desempeña un papel crucial en garantizar la operación, escalabilidad y eficiencia energética de los data centers.

El próximo 28 de noviembre, a partir de las 9 am (horario central de México) el broadcast gratuito DCD>Innovación y Diseño Latam contará con expertos de la industria para discutir las nuevas tendencias en el diseño de los data centers en la región. El evento online contará con la presencia de especialistas de Equinix, KIO, Scala Data Centers, Gtd Chile, Huawei, LZA Engenharia, Hostdime, Green and Smart Solutions y Claro.

Para Eduardo Carvalho, Managing Director de Equinix Latam, una tendencia principal es el uso de diseños estandarizados que permitan implementar rápidamente soluciones optimizadas y eficientes en múltiples sitios.

Según Carvalho, crecimiento y mayores densidades son los principales desafíos a la hora de diseñar un data center. «A medida que aumenta la demanda, las empresas necesitarán edificios más grandes y más capacidad. Centros de datos que respaldan el crecimiento económico en LATAM con los servicios necesarios para respaldar ese crecimiento. Empresas globales que crecen en toda LATAM con mayores necesidades de conectividad en sus plataformas globales. Todo ello apoyado en una política abierta de los países a las inversiones extranjeras para desarrollar nuevos mercados a nivel local».

Otro gran desafío, según Carvalho, es revisar las regulaciones locales que cambian sustancialmente de un país a otro, especialmente aquellas centradas en permisos de terrenos y construcción.

«La debida diligencia es clave para detectar tempranamente riesgos potenciales y comenzar a planificar con una visión estratégica el mejor enfoque para cumplir plenamente y proteger el proyecto y la marca Equinix frente a factores externos. (Ambiental, energético, político entre otros). También la cadena de suministro es un tema importante. Los materiales de construcción y la disponibilidad cambian de un país a otro y son clave para mantener la coherencia entre los IBX, así como para mantener los costos y el cronograma de construcción al día», explicó.

Ascenty destaca innovaciones en las arquitecturas eléctricas y climatización

Felipe Caballero, VP de Proyectos, Ingeniería y Construcción de Ascenty, mencionó que, aunque «menos resilientes», algunas nuevas tendencias marcan el mercado actual en cuanto al diseño de los nuevos centros de datos. «Un ejemplo son las arquitecturas eléctricas llamadas 5 por 4, así como las 4 por 3, donde solo una línea de energía actúa como soporte adicional para todo el sistema. Además, otra tendencia es la instalación de sistemas de climatización para mantener los racks entre 26 y 28 grados Celsius», dijo Caballero.

El VP de Ascenty explica que la eficiencia no «nace» únicamente en el diseño del data center, sino que depende del tipo de servidores o máquinas de cómputo a los que el centro de datos va a atender. «A partir de esto, se pueden determinar qué tecnologías deben ser utilizadas para el mejor rendimiento de la infraestructura». Los principales desafíos en el diseño, según Caballero, están relacionados con los tipos de servicios que serán atendidos.

En el caso de los hiperscalers, cada cliente tiene sus propios estándares de instalación, tipo de servidores, diseño, temperatura y humedad de operación, voltaje, tipo de conexión en los racks, etc. Lo ideal es realizar un diseño personalizado para el cliente con determinaciones claras y objetivas de cada sistema a ser instalado«, enfatizó.

Según él, los data centers del futuro no serán conceptualmente muy diferentes de lo que son hoy en día. «Necesitaremos infraestructuras robustas, resilientes y eficientes para atender a las nuevas tecnologías y demandas que están por venir. Reinventarse constantemente siempre ha sido el desafío principal de los diseñadores de este mercado desde siempre».

Scala Data Centers: «La principal tendencia está relacionada con el avance de la Inteligencia Artificial»

Agostinho Villela, VP de Ingeniería de Scala Data Centers, afirma que una de las principales tendencias en el diseño está intrínsecamente relacionada con el avance de la inteligencia artificial y sus áreas, como el Machine Learning y la Inteligencia Artificial Generativa, siendo esta última la que más ha crecido. «Estas tecnologías están desempeñando un papel fundamental en la forma en que se diseñan y operan los data centers, con un impacto directo en el aumento de densidades por rack», explicó Agostinho.

Según el VP, los principales proveedores de servicios en la nube, especialmente aquellos que operan a escala hiperscale, están liderando esta transformación. «Están impulsando la demanda de infraestructura de data centers que pueda soportar cargas de trabajo altamente intensivas en computación, caracterizadas por el procesamiento masivo de datos y la ejecución de algoritmos complejos».

En términos concretos», continúa Agostinho, «observamos que las densidades por rack están aumentando. Inicialmente, las configuraciones típicas de los racks podían variar de 2 a 5 kW de consumo de energía. Luego, crecieron hasta 10 kW, llegando actualmente a 20 kW. Sin embargo, con la llegada y proliferación de las aplicaciones de IA, ya existe demanda por encima de 40 kW. Este aumento en la densidad de energía es una respuesta directa a las necesidades de procesamiento de estas tecnologías avanzadas».

Agostinho afirma que estas innovaciones también afectan los requisitos de enfriamiento. «A medida que la densidad por rack aumenta, los data centers están adoptando soluciones de enfriamiento más eficientes e innovadoras, como la refrigeración líquida y sistemas de gestión térmica de alta precisión, que generan un mayor consumo energético».

Él destaca que al diseñar un data center es importante considerar «el costo, las restricciones urbanas, las normas técnicas, la eficiencia energética y, por supuesto, las especificaciones del cliente«.

«Cuando se trata de eficiencia y escalabilidad en el diseño de data centers, nuestro innovador y propietario método de construcción y diseño FastDeploy se destaca como una solución altamente eficiente y escalable en varios aspectos. Una de sus características fundamentales es la modularidad, lo que nos permite implementar rápidamente, garantizando una disponibilidad ágil de la infraestructura de TI. Estas estructuras modulares también facilitan la expansión futura y la adaptación a las necesidades en constante cambio, con un crecimiento gradual», explicó Agostinho.

Otra característica esencial de FastDeploy, según él, es aprovechar al máximo los espacios disponibles en los terrenos. «Todo esto en la mitad del tiempo de construcción en comparación con la metodología tradicional, lo que por sí solo reduce la huella ambiental, además de involucrar la industrialización en el proceso de construcción del centro de datos, y, por lo tanto, menos desperdicio en comparación con una obra convencional, lo que también contribuye a la reducción de la huella ambiental».

Agostinho vuelve a destacar que el futuro del diseño de data centers está siendo moldeado por el avance de la Inteligencia Artificial (IA) y las nuevas tecnologías, trayendo consigo desafíos e innovaciones significativas.

«Una de las tendencias más destacadas es el aumento de la densidad de racks, como se mencionó anteriormente. Creemos que pronto los racks superarán capacidades de 70 kW, y ya se habla en el futuro de llegar a racks de hasta 300 kW, principalmente con el crecimiento de la IA Generativa multimodal. Esto se debe a la creciente demanda de procesadores de alto rendimiento, como las GPUs (Unidades de Procesamiento Gráfico, responsables del procesamiento de gráficos), que son esenciales para tareas de IA intensivas en computación».

Deerns: «Vemos una tendencia general de utilizar medios más optimizados para la colaboración»

Tabajara Morais, Gerente de Proyectos en Deerns, destaca que ve una tendencia general de utilizar medios más optimizados para la colaboración, ya sea colaboración local o en la nube. «La colaboración en la nube ofrece varias ventajas, ya que podemos acceder desde cualquier lugar del mundo que tenga acceso a Internet y a esta plataforma, lo que flexibiliza su uso en el día a día. Otra forma de colaboración es la colaboración local, requerida por algunos clientes específicos. En la colaboración local, debemos tener una red de intranet no accesible desde fuera para acceder a los archivos y realizar la colaboración», explicó Tabajara.

Según él, una de las principales metodologías que se está difundiendo cada vez más es el BIM, donde la información de los dibujos se trabaja de manera inteligente y tiene parámetros que funcionan como una base de datos. «Con el uso de una plataforma BIM, tenemos la capacidad de convertir estos dibujos en formatos aceptados por diversas otras plataformas, garantizando la interoperabilidad en el trabajo».

Tabajara analiza que el mercado de data centers en América Latina está actualmente «muy activo», con una demanda de nuevos centros de datos que cumplan con estándares internacionales. «Estos estándares se dividen en dos categorías principales: los estándares europeos y los estándares de Estados Unidos. En el pasado, en Latinoamérica, se utilizaron tecnologías que habían sido descontinuadas hace tiempo en los mercados estadounidense y europeo. Pero actualmente estamos mucho más cerca y utilizando las mismas tecnologías que están consolidadas en el extranjero. Sin embargo, nuevas tecnologías que aún están en fase de pruebas en Europa y Estados Unidos no se han difundido lo suficiente en estos lugares como para llegar a América Latina y ser utilizadas aquí», explicó.

Él afirma que la eficiencia de un data center depende en gran medida de la solución de aire acondicionado adoptada. «Cada solución tiene sus ventajas y desventajas, y la guía principal para la adopción de cualquier solución son las condiciones climáticas locales. Vemos muchas soluciones innovadoras que, incluso en condiciones climáticas locales desafiantes, utilizan sistemas que no requieren enfriamiento mecánico, solo ventilación y sistemas evaporativos».

Según Tabajara, al no utilizar el enfriamiento mecánico con «expansión y condensación de gases refrigerantes», el consumo de energía se reduce drásticamente en comparación con soluciones que emplean este tipo de sistema. «El sistema de ventilación con capacidades evaporativas adiabáticas garantiza su escalabilidad mediante el número de equipos dimensionados, aumentando los equipos de manera lineal en relación con la carga», explicó.

En el futuro, Tabajara cree que se utilizarán ampliamente estudios más profundos con «diseño regenerativo interactivo» para lograr una definición optimizada con diversos estudios de diseños diferentes a una velocidad y escala simplemente no posible.

«Con el avance de las tecnologías de IA que se están difundiendo cada vez más, debemos tener cada vez más cuidado con la alineación entre la solicitud que realizamos a la IA y el resultado que la IA nos proporciona, debe ser compatible. Este no es un problema solo para el diseño, sino para la Inteligencia Artificial en su conjunto», aclaró.

LZA Engenharia: «Data centers más escalables»

Jonatha Giadanes, Director de Ingeniería de LZA Engenharia, señala que los hiperscalers están emergiendo como potencias cada vez más grandes en Sudamérica, siguiendo lo que ya ocurre en América del Norte. «Vemos que la tendencia es un aumento en la temperatura de los pasillos fríos, con activos preparados para ello, tratando así de equilibrar este crecimiento con la disponibilidad de energía», dijo.

Según Giadanes, los data centers se están estandarizando para que funcionen de manera «independiente y escalable». «Entendemos que la solución modular tiene sentido, incluso si el gasto de capital (CAPEX) es mayor a largo plazo, le brinda al cliente la posibilidad de invertir de manera escalable y seguir su propio crecimiento en ventas. Los nuevos conceptos de diseño muestran que los centros de datos, con la potencia y la refrigeración trabajando de manera individual y compartiendo la copia de respaldo, son más escalables y pueden ser igual de eficientes que otras soluciones si se utilizan las tecnologías adecuadas», explicó.

El Director de Ingeniería destaca los principales desafíos a la hora de diseñar un data center. «El estudio inicial, con un buen Due Diligence, es un elemento que a menudo se pasa por alto pero de gran importancia, ya que factores como la disponibilidad de energía y la conectividad son cruciales y se verifican en esta etapa del proyecto. Durante la fase de diseño, es necesario tener una clara comprensión de los procesos legales, la nacionalización de equipos y las normativas aplicables. La modularidad es otro aspecto que siempre debe considerarse, ya que esto no afecta solo al cliente, sino también a la disponibilidad de energía en un país en su conjunto».

Para Giadanes, es un gran desafío pensar en el futuro del diseño de data centers, ya que los avances en tecnología generan una gran demanda de procesamiento. «Es un mercado que tiende a seguir creciendo mucho en los próximos años. Hablando de tecnología, nuestra visión es que conceptos básicos de diseño, como la temperatura del DH (sistemas de distribución de calor) y la distribución de la capacidad de generadores, tienden a cambiar, incluso considerando propuestas que ya estamos estudiando con proveedores asociados, desempeñando un papel muy importante con estas soluciones», concluyó.

Vertiv destaca el diseño modular y la energía

Robson Pacheco, Gerente de Ventas de Vertiv Brasil, también cree que el diseño ha evolucionado e innovado significativamente en los últimos años. «Algunas de las principales tendencias incluyen el uso de fuentes de energía renovable, sistemas de enfriamiento más eficientes y sostenibles, la incorporación de tecnologías de gestión de datos en la nube y la adopción de diseños modulares para aumentar la escalabilidad y flexibilidad de los centros de datos», dijo Pacheco, y continuó: «Además, la creciente preocupación por la seguridad física y cibernética ha llevado a un mayor enfoque en medidas de seguridad y redundancia, así como a la incorporación de recursos de inteligencia artificial y aprendizaje automático para monitorear y proteger los data centers contra amenazas».

Según el Gerente de Ventas, la modularidad es cada vez más popular para permitir la expansión fácil y rápida del data center en etapas, según sea necesario. «Esto puede incluir el uso de módulos prefabricados que se entregan al sitio de construcción para su ensamblaje. En cuanto a la eficiencia energética, el aumento de los costos de energía y la creciente preocupación por el medio ambiente están impulsando la necesidad de proyectos más eficientes en términos de energía. Esto puede incluir el uso de tecnologías de enfriamiento más avanzadas, como sistemas de enfriamiento líquido, así como soluciones de iluminación y suministro de energía más eficientes», concluyó.

Pacheco también destaca el ascenso del edge computing. «Con el crecimiento de Internet de las cosas (IoT) y la necesidad de procesamiento de datos en tiempo real, el edge computing está ganando popularidad. Este enfoque coloca data centers más pequeños y más cerca de los usuarios finales, reduciendo la latencia y mejorando la experiencia del usuario. Además, los centros de datos modernos son cada vez más automatizados, con el uso de sistemas de gestión remota que permiten a los administradores monitorear y controlar el data center desde cualquier lugar del mundo».

Él concluye: «Los data centers actuales deben superar una serie de desafíos, que van desde la gestión del consumo de energía y la eficiencia operativa hasta garantizar la seguridad de datos sensibles. Cada detalle, desde la selección cuidadosa del lugar hasta la disposición estratégica de los racks y la implementación de sistemas de enfriamiento, desempeña un papel fundamental en el rendimiento, la confiabilidad y la sostenibilidad de estos centros de procesamiento de información. Creo que es difícil afirmar cuál es el diseño más eficiente, sin embargo, las inversiones que se realizan de manera proporcional a las demandas (construcción escalonada) han demostrado ser el modelo con una mayor adopción de implementación».